Полная версия

Полная версияСемантический Ренессанс

Первый раз человечество испытало шок, лет 80 назад, когда компьютеры еще только появились. Оказалось, что машины выполняют арифметические вычисления в миллионы раз быстрее человека. В тот момент, равно, как и много столетий перед этим, основным вычислительным инструментом были счёты, логарифмическая линейка и механический арифмометр. Счёты были в каждом магазине, а продавцы были чемпионами по сложению. Сложные расчеты, скажем, конструкция большого корабля или полет ракеты, выполнялись на логарифмической линейке гигантскими командами инженеров.

Уже через 10-15 лет быстродействие компьютеров воспринималось на социальном уровне вполне обыденно.

Следующая мощная веха связана с игрой в шахматы. Компания IBM в 90-х годах разработала шахматный суперкомпьютер Deep Blue. Это чудо 11 мая 1997 года выиграло матч из 6 партий у чемпиона мира по шахматам Гарри Каспарова. Сейчас уже многие забыли о том шоке, когда машина оказалась сильнее, «умнее» человека, правда в ограниченной области.

Пару слов о собственно названии «искусственный интеллект». Следует понимать, что в настоящее время в этом названии высокую долю занимает банальный маркетинг. Часто, в цифровой интеллект включаются характеристики, которые имеют вполне «не-интеллектуальное» происхождение.

Если же говорить об «интеллектуальных» свойствах компьютера, то серьезный и теоретический, и практический разговор на эту тему возник где 70-х годах прошлого века. Тогда тема получила название «экспертные системы». Зафиксируйте этот момент, 70 лет тому назад.

В то время начали обсуждать вполне практическую задачу, как можно заменить дорогостоящих и уникальных экспертов. Например, есть данные сейсморазведки по широкому региону. Может ли машина дать рекомендации по наличию месторождений нефти, с той же точностью как геолог высочайшей квалификации. Или, пример из медицинской темы, есть данные обследований пациента, может ли машина поставить диагноз.

Реализованный пример из физики – поиск новых элементарных частиц. На ускорителях делают миллионы снимков столкновений частиц. Эти снимки анализируются именно экспертными системами, а потом за открытия дают Нобелевские премии. Так что, здесь тоже можно дискутировать, кому давать премию, коллаборации ученых или эксперту-роботу.

В последующем тематика «экспертные системы» плавно перешла в тему «искусственный интеллект». Например, известная сейчас тема BigData – работа со сверхбольшими объемами данных. Методика здесь едина, что искать селфи элементарной частицы среди миллионов снимков, что анализировать поведение аккаунтов в социальной сети среди миллиарда пользователей.

Справедливости ради, надо отметить существование и общетеоретических разработок в теме цифрового интеллекта. Для формирования общей картины необходимо ссылочно описать и эту компоненту. Об этом следующий раздел.

лекторий ● Тест Тьюринга

В наше время тема машинного интеллекта чрезвычайно притягательна. И ученые, и практики грызут эту тему независимо от философских проблем. К примеру, на самом известном агрегаторе научной информации https://arxiv.org, есть раздел, посвященный только искусственному интеллекту Artificial Intelligence, https://arxiv.org/list/cs.AI/recent. Агрегатор arxiv.org управляется Cornell University, USA и дает возможность быстрой публикации практически без рецензии. Ученые со всего мира сначала публикуют статью в arxiv.org, чтобы «застолбить» свой приоритет, и лишь затем продвигают статью в статусные, но рецензируемые журналы. Как видим, тема искусственного интеллекта позиционируется наравне с самыми продвинутыми областями физики и математики. Интерес к теме демонстрируется количеством статей, примерно 100 штук от авторов со всего мира в одну среднюю неделю 2018 года. Это весьма немало и сравнимо с такими разделами, как биофизика.

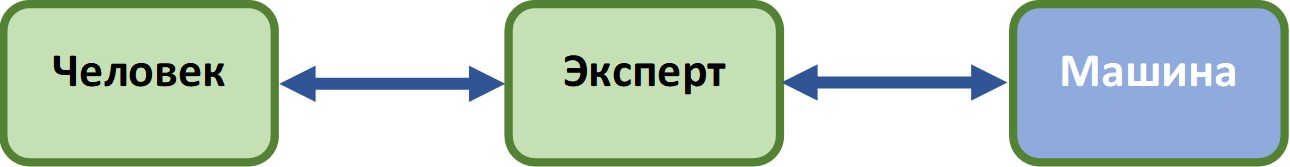

Тьюринг был первым, кто предложил научный подход в понимании цифрового интеллекта. И именно он перенес взгляд с общей теории на сравнение человеческого и машинного интеллектов. Еще в 1950 году он предложил удивительно простой инструмент, получивший название «тест Тьюринга» для сравнения двух интеллектов.

В трех комнатах находятся: (1) Эксперт; (2) Подопытный человек; (3) Машина. Эксперт задает текстовые вопросы подопытному человеку и машине. Вопросы задаются посредством обмена сообщениями, также, как мы обмениваемся на смартфонах. Вопросы можно задавать на любые темы. В этом, кстати, отличие от экспертных систем. Для вопросов есть единственное ограничение – формулировка вопроса должна допускать только один из двух ответов, либо Да, либо Нет. Ответы от Подопытного и Машины поступают эксперту в абсолютно одинаковые моменты времени. То есть, на экране Эксперта появляются два ответа. Таким образом, для Эксперта внешне нет никакой разницы в коммуникациях «Эксперт-Человек» и «Эксперт-Машина». Есть разница только в смыслах.

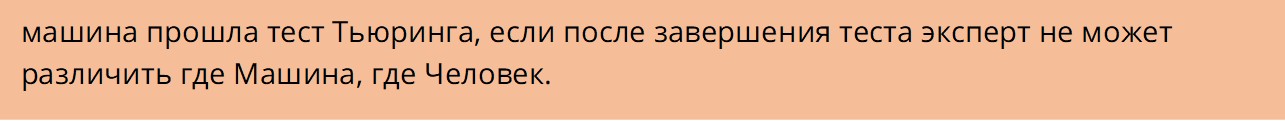

Считается, что

К примеру, вопрос: «Достоевский представитель русской литературы?». Любой образованный человек знает мгновенный ответ. Большинство программ искусственного интеллекта просто подвиснут на этом вопросе, включая, победителя по шахматам.

Тьюринг предложил свой тест 70 лет назад. За прошедшие годы тест неоднократно модифицировался и уточнялся, стал толчком ко множеству других продвижений в искусственном интеллекте. Появились специальные компьютеры, разработанные специально под прохождение теста. Тем не менее, насколько известно автору, на 2018 год ни одна машина еще не прошла полноценный тест Тьюринга. Если ограничить тему беседы, скажем, классическая музыка 19 века, то тогда машина может вести себя человекоподобным образом.

Важно понимать, что со строгой научной точки зрения факт прохождения теста Тьюринга еще не означает полноценного интеллекта у машины. Тут действует обратное утверждение, если машина не прошла тест Тьюринга, то у машины точно нет интеллекта. Другими словами, прохождение теста не означает, что машина может сочинять, как Чайковский, или писать, как Толстой.

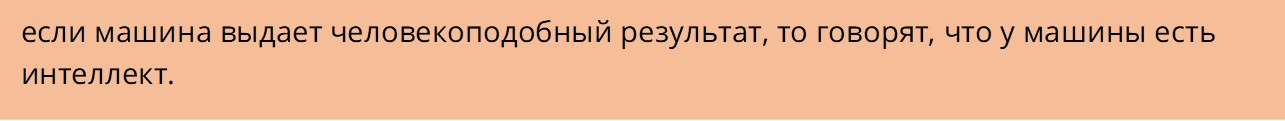

Тем не менее, именно тест Тьюринга привел к росту интереса к машинному интеллекту за счет научно неверного, но популярного правила:

Понятно, что это перебор, но так уже сложилось. Таковы законы маркетинга.

лекторий ● Как работает цифровое ранжирование

Завершаем философию цифрового интеллекта и поговорим об умном ранжировании от поисковых компаний.

Наверное, все понимают, что поисковики относятся к тексту, как к набору букв, точнее говоря, неких символов. В свою очередь, каждый символ – это некоторое число. То есть, любой текст трансформируется в поток чисел. Каким образом такой, пусть и большой набор чисел может приобретать знакомый нам, людям смысл? Мы же легко делаем выводы: это умная книга, а это глупые мысли.

Как ни покажется удивительным, во всем мире нет публичных людей, которые могли бы абсолютно достоверно изложить нюансы поисковых технологий от Яндекса или Гугла. Причина, как уже говорилось, банальна, поисковые компании считают свои технологии абсолютной тайной.

Все, что мы можем сказать о поисковых новациях будет построено на дозированных инъекциях от поисковых компаний или на экспериментальном тестировании. Плюс на знании принципов цифрового интеллекта/экспертных систем. Думается, для представителей бизнеса этого будет достаточно для принятия решений по теме, как нужно реагировать на семантическое ранжирование. Конечно, если возникает желание самим создавать системы с искусственным интеллектом, то надо погружаться в специальную литературу.

Начинаем с простых, но малоизвестных моментов.

Поисковики собирают информационные айсберги

Многие пользователи Интернета предполагают, что поисковые компании запоминают их запросы. Это, естественно, так. Ввели запрос, скажем, «лучшая вакансия в Питере», и поисковик занес запрос в свой архив. Плюс занес информацию о заказчике. Мало кто знает, что практически каждая страница Интернета содержит «шпионский» робот от Гугла и Яндекса. Когда пользователь открывает и читает веб-страницу, то робот отсылает поисковикам немало информации: цифровой адрес пользователя, тип компьютера, время просмотра и т.д. Такая шпионская слежка считается легальной во всем мире. Понятно, что роботы появляются с согласия владельцев страниц, взамен владельцы получают отчеты с анализом пользователей. Например, в Яндексе эта система называется «Яндекс.Метрика».

Все отчеты роботов хранятся в гигантских базах данных. Только анализ этих баз может уже дать массу информации, независимо от степени «интеллектуальности» анализирующей системы. Очевидные примеры до-интеллектуальной обработки:

● страницы, которые смотрят, читают долго, имеют более высокий ранг, чем страницы, которые закрывают сразу после открытия;

● по спектру загружаемых страниц можно детализировать профиль пользователя: пол, возраст, социальный статус; исходя из детального профиля можно уточнять ранг страницы.

Для более серьезного анализа используются:

Экспертные системы на нейронных сетях

Экспертные системы возникли примерно 70 лет назад и были основаны на идее использовать человеческий опыт генерации новых знаний. Как мы, люди, производим новые знания? Знания рождаются в результате периодически повторяющегося цикла:

1. поиск эксперта;

2. обучение нового эксперта;

3. новый эксперт становится генератором новых знаний.

Идея экспертных компьютерных систем была простой.

● Стартовым экспертом всегда является человек, специалист в данной области знаний.

● Новым экспертом является компьютер, который должен как-то принять знания от эксперта, стать экспертом и генератором знаний.

Не обязательно, чтобы компьютер, как креативный генератор был умнее эксперта. Эксперты всегда дороги и редки, поэтому возможность хотя бы в чем-то их заменить всегда будет полезной.

Специально для обучения экспертным знаниям появились специальные компьютерные компоненты, нейроны. Цифровые нейроны были полной трансляцией наших знаний о работе биологических нейронов. Часто работы биофизиков по человеческим нейронам и компьютерные разработки шли параллельно.

Как многие слышали, человеческие нейроны являются кирпичиками нашей умственной системы. Точно такую же роль играют и цифровые нейроны в цифровом интеллекте. И цифровые, и биологические нейроны обладают важнейшим свойством: умением обучаться и запоминать действия. Именно на этом свойстве основаны дрессировка животных и обучение человека.

Нейроны могут получать информацию из внешнего окружения. Прежде всего, это входная информация, которую нужно проанализировать и выдать «умный» результат. Для примера, биоробот получает информацию от множества расположенных в нем датчиков. Плюс нейрон получает базовые знания от экспертов. Самое важное: нейрон может передавать информацию другому нейрону, который, в свою очередь, обрабатывает ее и передает результат следующему нейрону.

Возникает сеть из нейронов, нейронная сеть, которая, действительно, может научиться функционалу, совершенно не похожим на свойства идейно простых процессоров из арифметического калькулятора.

Конечно, нейронную сеть можно научить выполнять арифметические действия. Но это будет стрельбой из пушки по воробьям. Есть масса задач, когда нейронные технологии показывают суперрезультаты. Самый банальный пример, необходимо классифицировать фотографии в некую структуру, скажем, из нескольких позиций: люди, животные, неживая природа, дома, прочее. Сначала сеть проходит обучение у эксперта-человека, который смотрит фото и «раскладывает» их по папкам. Сеть наблюдает за действиями человека, вырабатывает и шлифует свой собственный алгоритм обработки. Постепенно, точность алгоритма нейронной сети растет и сеть может уже самостоятельно обрабатывать фото.

К настоящему времени, объем литературы по нейронным сетям уже невообразим. Практически все технические ВУЗы учат нейронным техникам.

Именно нейронные сети используют поисковые компании для ранжирования Интернет материалов. И именно поэтому описание работы нейронных сетей поисковиков является их главным секретом.

Вдумчивый читатель тут же может обратить внимание на важность стартового эксперта. Хорошо, скажет он, нейроны это супер, с классификацией фото понятно. Тут достаточно одного эксперта. Он поработает пару дней, и нейронная сеть будет просто повторять действия эксперта, используя опыт эксперта как образцы. Как быть с морем информации в Интернете, с миллиардами страниц? Навскидку, тут нужны тысячи и тысячи экспертов.

Вы удивитесь, но дело происходит именно так. Как говорилось, недавно Яндекс презентовал последнюю версию своей поисковой технологии «Королев» и раскрыл некоторые её детали. Презентацию можно посмотреть здесь https://yandex.ru/korolev/. Только вдумайтесь в заявленные цифры:

● В нейронную сеть Яндекса было передано 2 миллиарда оценок для обучения нейронной сети, говорят в Яндексе.

● К компании постоянно работают свыше тысячи человек – экспертов, которые занимаются только подготовкой и проверкой правильных оценок. Профессия называется асессор.

● Помимо штатных работников Яндекс нанял через систему Яндекс.Толока свыше миллиона внештатных асессоров, с помощью которых и были приготовлены миллиарды правильных оценок, https://toloka.yandex.ru/.

Думаю, по числу вовлеченных это один из самых крутых проектов.

Наличие миллиона участников удаляет любую мистику с категории цифровой интеллект. Еще раз вдумайтесь, миллион человек учат одну машину делать тоже самое, что и один человек, по большому счету.

Большие числа

Другой пример. Яндекс каждому тексту ставит в соответствие пакет чисел, или, как говорят в математике, вектор. Каждый вектор Яндекса содержит 300 чисел. В результате Яндекс получает невообразимое число текстовых комбинаций. Допустим, отдельное число в векторе Яндекса принимает лишь числа 0, 1, 2, 3….9. Тогда число текстовых комбинаций Яндекса будет 10 в 300-й степени, 10^300.

Это убийственное число. Больше чем «охулиярд». Скажем, если каждый житель Земли напишет по миллиону разных статей, то число всех статей будет лишь 10^16, примерно миллиард миллиардов. Это практически бесконечно малая величина в сравнении с числом комбинаций Яндекса.

Если забыть умные слова – нейрон, интеллект, вектор, BigData – то умное ранжирование (на данный момент) сводится к простой схеме:

● Яндекс записал в качестве образцов выбор миллиона экспертов при просмотре миллиардов страниц;

● когда приходит новый запрос, то компьютер Яндекса просто находит похожий пример среди миллиардов образцов.

По сути, описанное выше означает превращение поисковой технологии в серьезную промышленную технологию. Задумайтесь, ведь мало кто понимает, как работает атомная электростанция. Даже большинство физиков имеют лишь популярное представление об атомной технике, не говоря о других инженерах. Да, мы рисуем картинку атома, протоны, электроны, но это создает лишь иллюзию понимания. С появлением семантического ранжирования и информационные технологии становятся такими же. Ими можно пользоваться, но понять их работу будет уже невозможно. Кстати,

промышленный характер умного ранжирования несет важные выводы для всего бизнеса.

До последнего времени всегда можно было разобраться, как действует функционал любой корпоративной программы. Даже сравнительно сложная финансовая аналитика на SQL запросах или на BI матрицах вполне понятны для корпоративных специалистов. Теперь впервые появляются программы, разобраться в которых уже нельзя, можно лишь «пощупать» технологию.

Именно здесь, как ни удивительно, возникает преимущество для бизнеса в случае семантического ранжирования. Невозможно соревноваться с промышленной технологией, нужно просто размещать в публичном пространстве материалы с достойным смыслом.

лекторий ● Ссылки и ключи сохранятся

Продолжим тему промышленного характера поисковых технологий. Сторонний наблюдатель, даже хорошо образованный специалист, не сможет детально разобраться в нюансах этой науки/технологии. Вместе с тем, бизнесу нужно представлять себе, какие существуют

Весь предыдущий текст говорит о том, что теперь первостепенным является смысл материалов, их интеллектуальная насыщенность и ценность. Здесь важно, что «смысл» понимается в естественной человеческой традиции.

Несмотря на первостепенное значение «смыслового» параметра, позиция в рейтинге также зависит и будет зависеть еще от двух важнейших параметров:

● наличие и вес перекрестных ссылок;

● насыщенность текста ключевыми словами и их структура.

Чтобы разобраться с этими параметрами немного напомним историю поисковых технологий.

Поисковики начинали с простого поиска

Поисковые системы в Интернете появились практически синхронно с появлением сайтов, в начале 1990-х годов. Первые технологии были простым поиском вхождения одного текста в другом тексте. С таким поиском знакомы все пользователи текстовых редакторов, например, MS Word. Если вбить в строку поиска искомую фразу, то Ворд сходу покажет все вхождения фразы в документе. Первые поисковые технологии отличались от Ворда лишь существованием роботов-читателей. Это программы, которые обходят все страницы Интернета. Слово «обходят» означает, что роботы «читают» страницы. В процессе чтения робот создает краткий образ страницы, которые иногда называется индекс. Индексы всех страниц сохраняются в архиве поисковой компании. Профессионалы процесс «чтения» называют индексированием.

Соответственно, когда пользователь вводит поисковую фразу, то поисковая программа сравнивает фразу с индексами из базы данных. Все совпадения составляют поисковый результат, который выдается в виде последовательного списка пользователю.

Морфология, как цифровая проблема

Первая проблема Интернет-поиска появилась практически сразу, особенно, в русском языке. В языке представлены разные морфологические формы с чрезвычайно близким значением. Прежде всего падежи: бизнес, бизнеса, бизнесу и т.д. Плюс другие способы словообразования, например, видеть, видение, или наоборот, индекс, индексирование. Практически всегда пользователю интересны все морфологические варианты. самостоятельный перебор всех морфологических форм сейчас кажется нонсенсом.

В русском сегменте Интернета полную морфологическую унификацию произвел Яндекс в середине 1990-х на основе словаря академика А. Зализняка. Все формы от одно слова – падежи, числа, новообразования – приводились к одной единице. Морфологическая унификация позволила Яндексу выйти на первое место в Рунете.

Вечная проблема ранжирования

Следующей возникла проблема больших чисел. Число страниц в поисковых результатах стало невообразимо большим. Пример, сейчас Яндекс находит фразу «столешница» в 739 миллионах страниц! Слово «бизнес» содержится примерно в 1 миллиарде страниц. Простой текстовый поиск, как в Ворде, здесь уже не справляется. Конечно, можно уточнять текстовый поиск, удлинять фразу, использовать логические операторы И/ИЛИ. Все это сложно и начинает требовать от пользователя специальных навыков.

Именно здесь впервые возникает задача ранжирования. Как расставить страницы по степени нужности (интереса и т.п.) для пользователя.

Мета-теги и ключевые слова

Первым способом решения задачи ранжирования стало применение мета-тегов. Каждая веб-страница в соответствии с протоколом HTML имеет видимую и невидимую часть. Видимая компонента – это тот материал, который мы видим на своем экране. Невидимая часть создается владельцем веб-страницы и анализируется только компьютером без вывода на экран. В частности, роботы-поисковики видят веб-страницу полностью. Специально для поисковиков протокол HTML допустил включение в невидимую часть специальных разделов, «тегов», с помощью которых владелец страницы может позиционировать свою страницу. Поскольку эти теги описывают всю страницу, то они получили специальное название «мета-теги».

Для поиска наиболее важны три мета-тега:

title: название страницы, обыкновенно кратко, этот текст браузер выводит в названии вкладки

description: описание, обыкновенно размером в абзац

keywords: ключевые слова, ключи, список наиболее важных слов из текста, как правило, в именительном падеже

К примеру, если слово «бизнес» имеется и в названии, и в описании, и среди ключевых слов, а также внутри видимого текста, то подобная страница получит более высокий рейтинг по сравнению со страницами, которые содержат слово «бизнес» только в видимой части.

За прошедшие 20 лет поисковики по-разному воспринимали значения мета-тегов. Были периоды, когда поисковики, вероятно, даже игнорировали мета-теги и доверяли только своему анализу.

Скорее всего, на 2018 год большинство мета-тегов уменьшили свой вес для ранжирования. В частности, по причине появления новых протоколов структурирования, скажем «микроразметка».

Исключением являются ключевые слова, что связано с фундаментальной особенностью семантической структуры каждого языка – существованием постоянных частотных спектров.

Представим себе все реальные тексты на одном языке. Подсчитаем количество всех слов в таком объединении, причем одно и тоже слово будем учитывать столько раз, сколько оно встречается в текстах. Подсчитаем число вхождений для выделенного слова. Частота вхождения определяется как отношение двух этих чисел. Как следствие, появляется частотный словарь: лексические единицы, расположенные по убыванию частоты.

Частоту вождения можно рассчитать не только по всем текстам, но и по отельному тексту или по группе текстов. Скажем по группе, объединенной отраслевым признаком – медицина, математика, геология, финансы. Или по газетным текстам. Оказывается, что частотный словарь газетных текстов содержит всего 300-500 слов. Как ни покажется удивительным, но для выделения большинства отраслей достаточно 100-500 ключевых слов. Лишь талантливые писатели используют словарь из нескольких тысяч слов.

С некоторой условностью частота вхождения обладает свойством постоянности: частота по выделенному тексту примерно совпадает с частотой по группе текстов. Это как раз то, что мы можем сразу сказать после прочтения текста: это медицинский текст, это инженерный, это литература. Вывод мы делаем по высокочастотным словам. Точно также текст может анализировать и машина. Она просто сравнивает слова в тексте (семантические единицы) с частотными словарями разных отраслей.

Отметим, что в Интернете используется термин «частота поисковых запросов», который методологически весьма близок к общей семантической частоте.

Подробнее об использовании ключевых слов в бизнесе поговорим в разделе «Составляем семантический базис» (см. содержание).

Революция Гугла

Следующим и, пожалуй, революционным шагом в задаче ранжирования для того времени стало использование Гуглом перекрестных ссылок.

Гугл предложил и внедрил простую идею из реальной жизни. Если вызывающие у Вас доверие люди говорят «этот продукт известен с хорошей стороны», то Вы поверите, и с высокой вероятностью обратите свое внимание на этот известный продукт.